Nemrégiben egy olyan eset rázta meg a technológia és katasztrófavédelem határmezsgyéjét, ami szerintem mindannyiunkat elgondolkodtat. 2025. december 8-án, éjjel 11:15-kor egy erős földrengés rázta meg Japán északi partvidékét, egészen pontosan Hachinohe városát az Aomori prefektúrában. A rengés intenzitása a japán skálán elérte a felső hatos fokozatot, ami már önmagában is komoly riadalmat okozott.

A földrengés és a cunami-riasztások menete

A Japán Meteorológiai Ügynökség azonnal reagált: cunami-riasztásokat adott ki Hokkaidóra, Aomorira és Iwate prefektúrákra, míg Miyagi, Fukushima és további területekre cunami-figyelmeztetést rendeltek el. Ezek a riasztások életbevágóak lehetnek, hiszen egy nagy erejű földrengést követő szökőár akár perceken belül elérheti a partokat.

Az események gyorsan követték egymást: december 9-én hajnalban, 2:45-kor minden cunami-riasztást figyelmeztetésre mérsékeltek, majd reggel 6:20-ra teljesen feloldották azokat. Ez így elsőre sima ügynek tűnik – de itt jön a csavar.

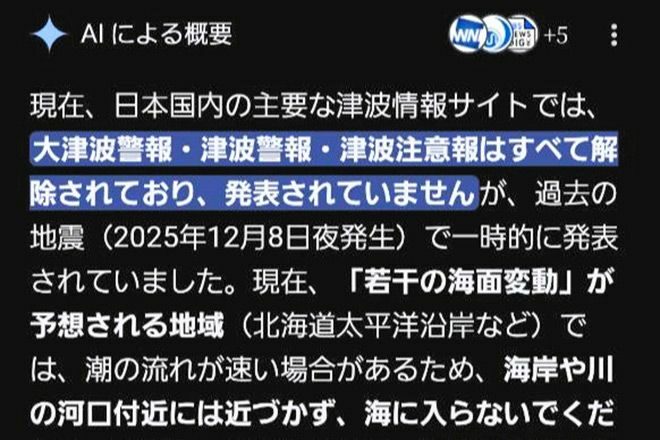

Google AI „AI Overviews” funkciója és a veszélyes tévedés

Képzeld el, hogy egy újságíró az Asahi Shimbun-tól éjjel fél háromkor rákérdez a Google keresőjében: „Mesélj a legfrissebb cunami-információkról!” A Google válasza az „AI Overviews” nevű generatív mesterséges intelligencia által összeállított összefoglaló volt: „Jelenleg minden nagy cunami-riasztást és figyelmeztetést feloldottak.” Csakhogy ez egyszerűen nem volt igaz – ekkor még érvényben voltak a riasztások és figyelmeztetések!

Nem csak egyszer fordult elő ez a baki: később kétszer is megkérdezték ugyanazt, és mindig ugyanazt a hamis információt kapták vissza. Ez pedig nem csupán kellemetlen baki, hanem potenciálisan életveszélyes félrevezetés lehetett volna.

Mi az az „AI Overviews”?

A Google keresőjében megjelent új funkció lényege, hogy több forrásból összegyűjtött információkat generatív AI segítségével összefoglalva jelenít meg közvetlenül a találati lista tetején. Ez kényelmes és gyors tájékozódást ígér – de vajon mennyire megbízható?

A szakértők véleménye: miért veszélyes az AI „hallucináció”?

Masahiro Tsuji, aki keresőmotorok működésében jártas tanácsadóként dolgozik a Faber Company Inc.-nél, nem kertelt. Szerinte az ilyen generatív AI által előállított válaszok komoly problémákat rejtenek magukban. Az úgynevezett „hallucináció” jelensége azt jelenti, hogy az AI olyan információkat állít elő, amelyek hihetőnek tűnnek, de valójában hamisak vagy elavultak.

Tsuji maga is órákon át kutatta az AI Overviews mellett a Google AI módját hajnalig a földrengés után. Az eredmény? Mindkét rendszer elavult vagy hibás adatokat adott vissza – például rosszul jelezte meg a földrengés magnitúdóját is.

„Egyetlen egyszer sem szabadna hamis információt megjeleníteni egy olyan területen, ahol emberek élete forog kockán,” hangsúlyozta Tsuji. Ez pedig nem csak technikai kérdés – ez emberi felelősség is.

Mire figyeljünk AI-alapú információk használatakor katasztrófák idején?

Az eset kapcsán Tsuji arra hívja fel mindenki figyelmét, hogy mindig ellenőrizzük az információ forrását. Egy generatív AI válasza önmagában nem garancia arra, hogy pontos vagy naprakész adatot kapunk. Különösen igaz ez akkor, amikor természeti katasztrófákról van szó.

Google egyébként idén ősszel vezette be japán nyelven ezt az AI módot. A cég reklámrészlege szerint az „AI Overviews” többségében hasznos és tényszerű információkat ad – de ha hibázik, akkor folyamatosan fejlesztik a rendszert ezek alapján.

Hivatalos ajánlások: kitől kérjünk segítséget baj esetén?

A japán kormány részéről Minoru Kihara kabinetfőnök is megszólalt december 9-én reggel egy sajtótájékoztatón. Ő azt javasolta mindenkinek, hogy katasztrófák idején kizárólag megbízható forrásokra hagyatkozzanak:

- a kormány hivatalos közleményei

- a helyi hatóságok tájékoztatói

- a hiteles médiajelentések

Kihara kiemelte: korábbi természeti katasztrófák során rengeteg ellenőrizetlen információ terjedt el online – ez pedig csak tovább nehezítette a védekezést és mentést.

Mit tanulhatunk ebből mi itthon?

Ez az eset számomra is egy erős figyelmeztetés volt arra nézve, hogy bár az AI lenyűgöző eszköz lehet gyors tájékozódásra, soha nem szabad vakon megbízni benne kritikus helyzetekben. Egy földrengés vagy árvíz idején egyetlen percnyi tévedés is emberéleteket követelhet.

Szerintem fontos lenne itthon is tudatosítani ezt: amikor vészhelyzet van, ne csak egy Google-találatra hagyatkozzunk! Nézzük meg több forrást, keressük meg az eredeti hivatalos közleményeket! És ha lehetőségünk van rá, hallgassunk szakértőkre vagy helyi hatóságokra.

Te mit gondolsz? Használnád-e te is ilyen AI-t vészhelyzetben? Vagy inkább maradsz a hagyományos híradásoknál? Írd meg kommentben!